Hadoop运行模式

Hadoop的三种运行模式

Hadoop官方网站:http://hadoop.apache.org/

Hadoop运行模式包括:本地模式、伪分布式模式和完全分布式模式。

- 本地模式:单机运行,只是用来演示一下官方案例。生产环境不用。

- 伪分布式模式:也是单机运行,但是具备Hadoop集群的所有功能,一台服务器模拟一个分布式的环境。个别缺钱的公司用来测试,生产环境不用。

- 完全分布式模式:多台服务器组成分布式环境。生产环境使用。

本地运行模式

创建在

/opt/module/hadoop-3.1.3/目录下面创建一个wcinput文件夹1

mkdir wcinput

在wcinput文件下创建一个word.txt文件

1

cd wcinput

编辑word.txt文件

1

vim word.txt

在文件中输入如下内容

1

2

3

4hadoop yarn

hadoop mapreduce

atguigu

atguigu保存退出:

:wq回到Hadoop目录

/opt/module/hadoop-3.1.3执行程序,指定执行jar包中的

wordcount程序,输入目录为wcinput输出目录为wcoutput1

hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-3.1.3.jar wordcount wcinput ./wcoutput

查看结果

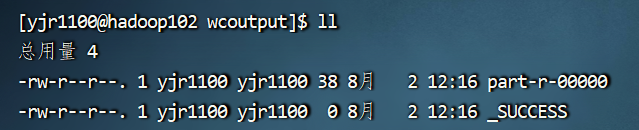

进入wcoutput目录有两个文件

下面这个

_SUCCESS文件只是一个标记,表示执行成功,里面并没有数据查看

part-r-00000文件1

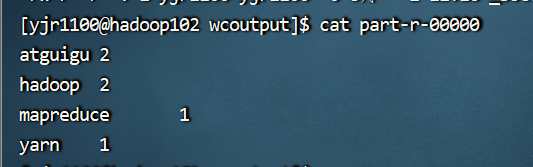

cat wcoutput/part-r-00000

看到如下结果:

注意:输出目录不能事先创建,如果已经有./output 目录,就要选择另外的

输出目录,或者将~/output 目录先删除

完全分布式运行模式

我们已经在 Hadoop102 上配置好了JDK和Hadoop的环境,下面我们需要给 Hadoop103和Hadoop104 也配置好环境

编写集群分发脚本xsync

scp(secure copy) 安全拷贝

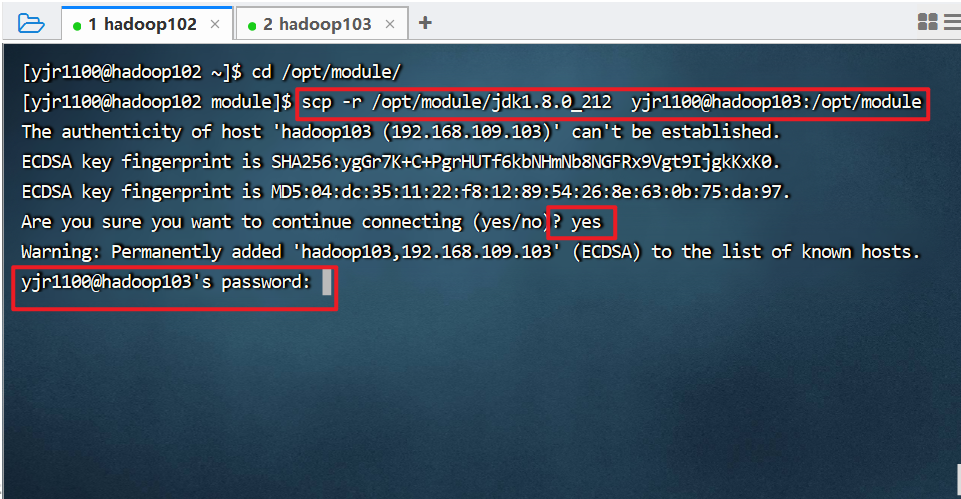

在hadoop102上执行

1

scp -r /opt/module/jdk1.8.0_212 yjr1100@hadoop103:/opt/module

需要输入hadoop103上yjr1100的密码如下图所示

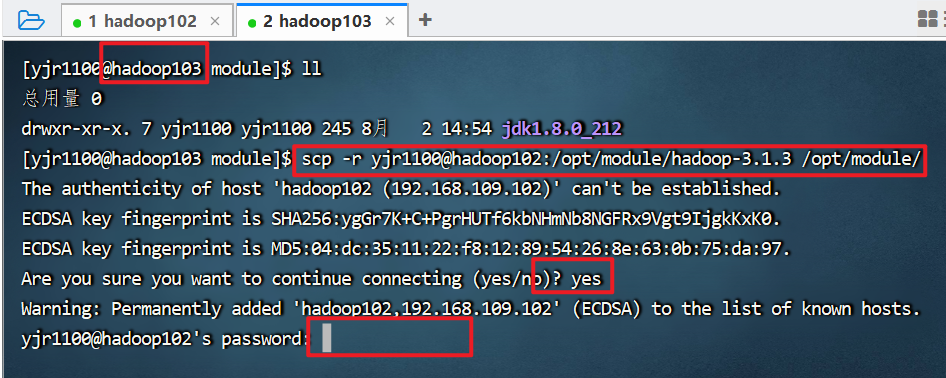

或者也可以在hadoop103上执行

1

scp -r yjr1100@hadoop102:/opt/module/hadoop-3.1.3 /opt/module/

我们可以看到在moudle目录下,刚才从hadoop102拷贝的jdk文件夹

同样,需要输入hadoop102上yjr1100的密码进行拷贝,如下图所示

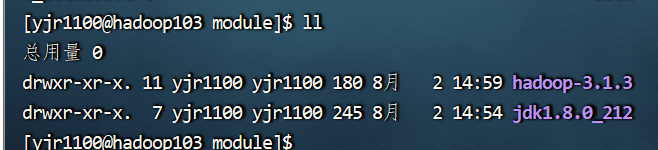

输入ll 可以看到,此时已经成功用两种方法拷贝从hadoop102中将文件拷贝到了hadoop103中

我们其实可以通过下面的命令,在hadoop103上将hadoop102上的数据拷贝给hadoop104

1

scp -r yjr1100@hadoop102:/opt/module/* yjr1100@hadoop104:/opt/module/

rsync远程同步工具

rsync主要用于备份和镜像。具有速度快、避免复制相同内容和支持符号链接的优点。

rsync和scp区别:用rsync做文件的复制要比scp的速度快,rsync只对差异文件做更新。scp是把所有文件都复制过去。

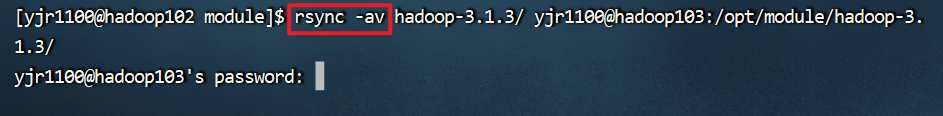

比如我们使用rsync来把hadoop102上的wcinput目录拷贝到hadoop103中,我们先把hadoop103上的/opt/module/hadoop-3.1.3/wcinput删除,然后在 hadoop102上执行下面的命令。

1

rsync -av hadoop-3.1.3/ yjr1100@hadoop103:/opt/module/hadoop-3.1.3/

我们可以发现,速度被刚才 scp 命令快了很多,因为许多hadoop相同的文件并没有进行拷贝,只拷贝了hadoop103中没有的 wcinput 目录

这里 -a 选项说明是归档拷贝操作,-v 选项说明显示复制过程

rsync 和 scp 命令比较像,都是 命令+选项+源地址+目的地址 四个部分,一般我们第一次拷贝的时候使用 scp 命令,以后同步的时候使用 rsync 命令

xsync集群分发脚本

每次使用上面两个命令,都要输入很多内容,为了更方便操作,我们可以编写一个脚本,每次进行执行

我们执行 echo $PATH 命令,看到 /home/yjr1100/bin 目录也在环境变量中,这意味着我们在这个目录下写入的脚本,可以在任何目录下执行,就和在任何目录下都可以执行 java 这个命令一样。

分别执行下面的命令可以实现在 /home/yjr1100/bin/ 目录下写入 xsync 脚本,脚本名字可以随便写,这里就写 xsync

1 | cd ~ |

在脚本中输入下面内容

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31 #!/bin/bash

#1. 判断参数个数

if [ $# -lt 1 ]

then

echo Not Enough Arguement!

exit;

fi

#2. 遍历集群所有机器

for host in hadoop102 hadoop103 hadoop104

do

echo ==================== $host ====================

#3. 遍历所有目录,挨个发送

for file in $@

do

#4. 判断文件是否存在

if [ -e $file ]

then

#5. 获取父目录

pdir=$(cd -P $(dirname $file); pwd)

#6. 获取当前文件的名称

fname=$(basename $file)

ssh $host "mkdir -p $pdir"

rsync -av $pdir/$fname $host:$pdir

else

echo $file does not exists!

fi

done

done

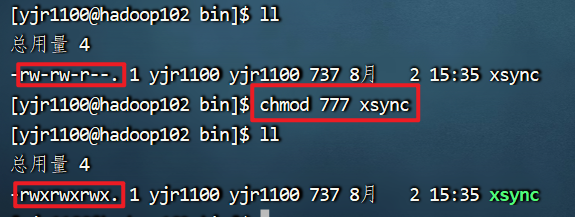

写完脚本后,给脚本执行权限 chmod 777 xsync

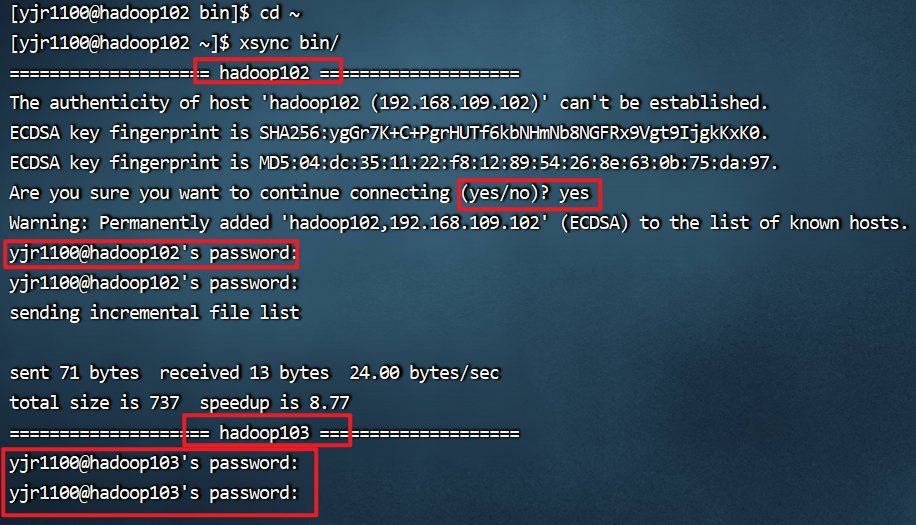

现在我们就使用 xsync 同步 bin 目录下的文件

1 | cd ~ |

如下图所示,输入服务器对应密码后,就成功的把 xsync 脚本分发给集群中的所有服务器了

如果我们使用root用户或者使用 sudo 来执行,一定要写全 xsync 的路径,因为 root 用户的$PATH 里面没有 /home/yjr1100/bin 目录,所以找不到 xsync 命令,除非我们像java那样,在 /etc/profile.d/ 目录下创建脚本。

ssh免密登录

刚才执行脚本的时候,我们每次都要输入密码,这个比较麻烦,我们配置ssh免密登录

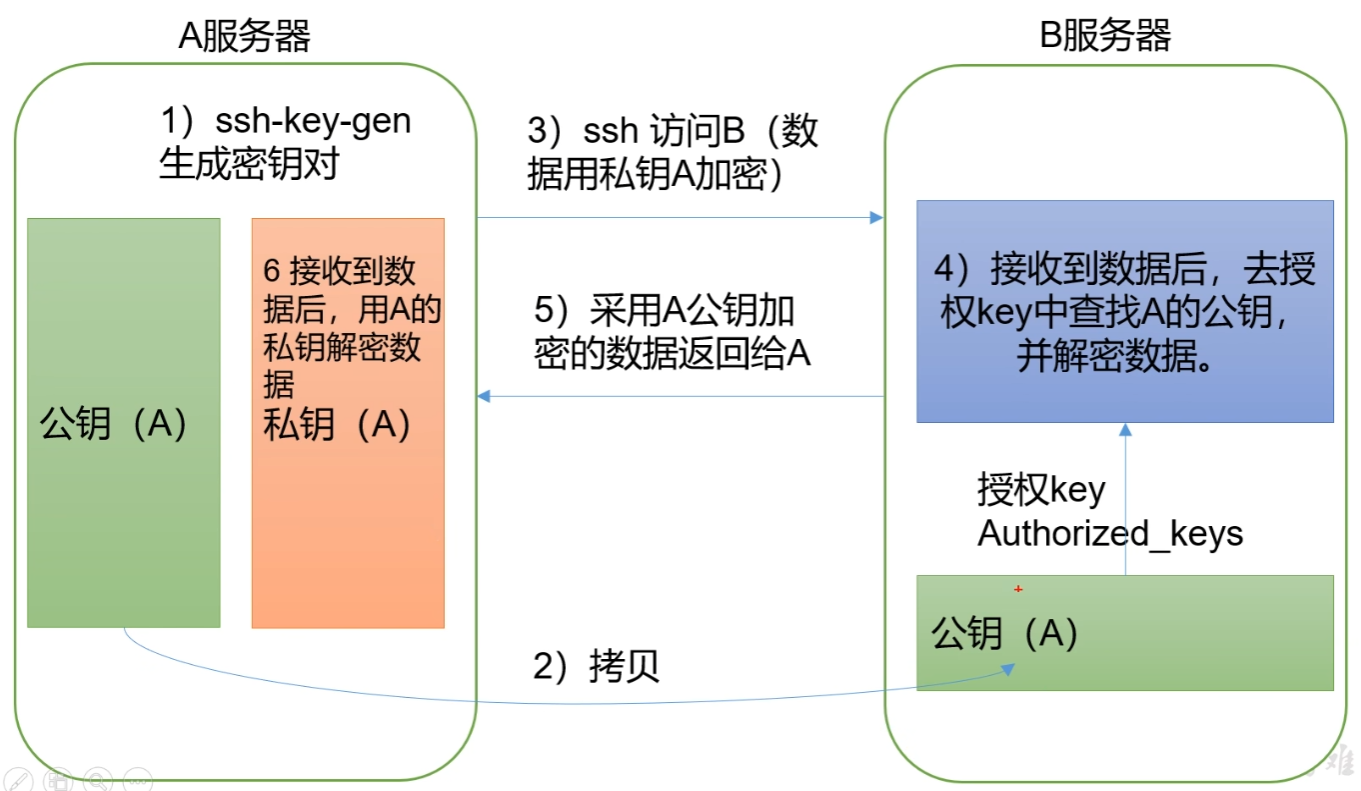

免密登录的原理

配置ssh免密登录

先配置102可以免密访问103,记得使用普通用户

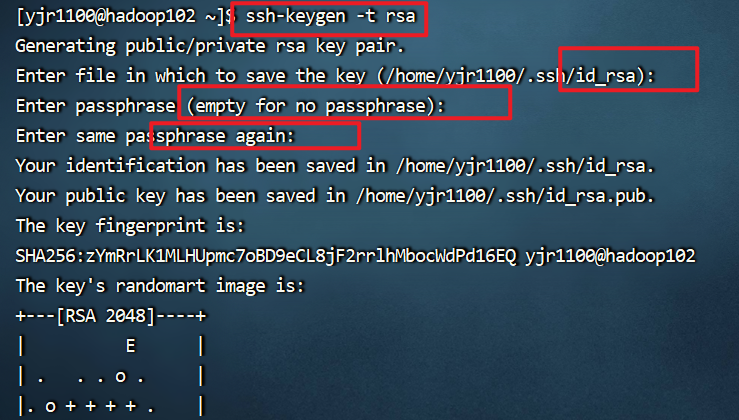

1 | ssh-keygen -t rsa |

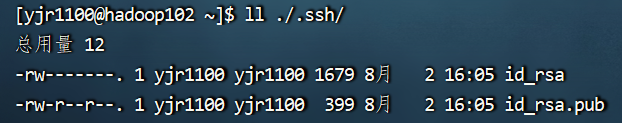

输入命令后,三次回车,可以看到如下图,密钥已经生成好了,在 /home/yjr1100/.ssh/ 下面有两个文件 id_rsa 和 id_rsa.pub 分别是私钥和公钥

我们将公钥拷贝给 hadoop103 和 hadoop104 ,也可以拷贝给自己

1 | ssh-copy-id hadoop103 |

重复上面的步骤,配置hadoop103和hadoop104上对其他服务器的免密登录

注意,这个只是普通用户在三个服务器之间的免密登录,如果我们使用root用户进行ssh登录,但是我们并没有配置root用户的公钥和私钥,所以root用户ssh登录是需要密码的。

我们可以切换root用户,重复上面的步骤进行配置

下面我们再使用 xsync 来同步一下环境变量,z这个需要root权限,我们可以sudo执行,主要要写全 xsync 的路径

1 | sudo /home/yjr1100/bin/xsync /etc/profile.d/my_env.sh |

注意再hadoop103和hadoop104 上使用命令 source /etc/profile 让环境变量生效

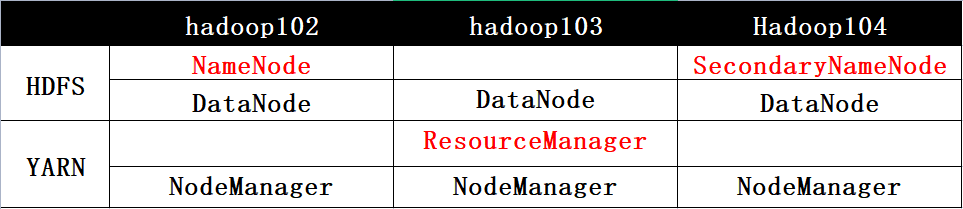

集群配置

集群部署规划

注意:

- NameNode和SecondaryNameNode不要安装在同一台服务器

- ResourceManager也很消耗内存,不要和NameNode、SecondaryNameNode配置在同一台机器上。

配置文件说明

Hadoop配置文件分两类:默认配置文件和自定义配置文件,只有用户想修改某一默认配置值时,才需要修改自定义配置文件,更改相应属性值。

- 默认配置文件

要获取的默认文件 文件存放在Hadoop的jar包中的位置 [core-default.xml] hadoop-common-3.1.3.jar/core-default.xml [hdfs-default.xml] hadoop-hdfs-3.1.3.jar/hdfs-default.xml [yarn-default.xml] hadoop-yarn-common-3.1.3.jar/yarn-default.xml [mapred-default.xml] hadoop-mapreduce-client-core-3.1.3.jar/mapred-default.xml - 自定义配置文件

core-site.xml、hdfs-site.xml、yarn-site.xml、mapred-site.xml四个配置文件存放在$HADOOP_HOME/etc/hadoop这个路径上,用户可以根据项目需求重新进行修改配置。

配置集群

核心配置文件

配置 core-site.xml1

2cd $HADOOP_HOME/etc/hadoop

vim core-site.xml文件内容如下

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

<configuration>

<!-- 指定NameNode的地址 -->

<property>

<name>fs.defaultFS</name>

<value>hdfs://hadoop102:8020</value>

</property>

<!-- 指定hadoop数据的存储目录 -->

<property>

<name>hadoop.tmp.dir</name>

<value>/opt/module/hadoop-3.1.3/data</value>

</property>

<!-- 配置HDFS网页登录使用的静态用户为yjr1100 -->

<property>

<name>hadoop.http.staticuser.user</name>

<value>yjr1100</value>

</property>

</configuration>HDFS配置文件

配置hdfs-site.xml1

vim hdfs-site.xml

文件内容如下

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

<configuration>

<!-- nn web端访问地址-->

<property>

<name>dfs.namenode.http-address</name>

<value>hadoop102:9870</value>

</property>

<!-- 2nn web端访问地址-->

<property>

<name>dfs.namenode.secondary.http-address</name>

<value>hadoop104:9868</value>

</property>

</configuration>YARN配置文件

配置yarn-site.xml1

vim yarn-site.xml

文件如下

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

<configuration>

<!-- 指定MR走shuffle -->

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<!-- 指定ResourceManager的地址-->

<property>

<name>yarn.resourcemanager.hostname</name>

<value>hadoop103</value>

</property>

<!-- 环境变量的继承 -->

<property>

<name>yarn.nodemanager.env-whitelist</name>

<value>JAVA_HOME,HADOOP_COMMON_HOME,HADOOP_HDFS_HOME,HADOOP_CONF_DIR,CLASSPATH_PREPEND_DISTCACHE,HADOOP_YARN_HOME,HADOOP_MAPRED_HOME</value>

</property>

</configuration>这里环境变量的继承算是3.1的一个小bug,3.2以后就不用配置了

MapReduce配置文件

配置mapred-site.xml1

vim mapred-site.xml

文件如下

1

2

3

4

5

6

7

8

9

10

<configuration>

<!-- 指定MapReduce程序运行在Yarn上 默认是local -->

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

</configuration>

在集群上分发配置好的Hadoop配置文件

1 | xsync /opt/module/hadoop-3.1.3/etc/hadoop/ |

群起集群

配置workers

1 | vim /opt/module/hadoop-3.1.3/etc/hadoop/workers |

内容就是集群中的服务器,注意:该文件中添加的内容结尾不允许有空格,文件中不允许有空行。

1 | hadoop102 |

同步所有节点配置文件

1 | xsync /opt/module/hadoop-3.1.3/etc/hadoop/workers |

启动集群

如果集群是第一次启动,需要在hadoop102节点格式化NameNode(注意:格式化NameNode,会产生新的集群id,导致NameNode和DataNode的集群id不一致,集群找不到已往数据。如果集群在运行过程中报错,需要重新格式化NameNode的话,一定要先停止namenode和datanode进程,并且要删除所有机器的data和logs目录,然后再进行格式化。)

1

hdfs namenode -format

启动HDFS

1

/opt/module/hadoop-3.1.3/sbin/start-dfs.sh

输入

jps可以查看当前服务器上的java进程的pid,此时hadoop102,hadoop103,hadoop104上的dfs服务都启动了在配置了ResourceManager的节点(hadoop103)启动YARN,因为我们前面规划的ResourceManager在hadoop103上

1

/opt/module/hadoop-3.1.3/sbin/start-yarn.sh

同样,输入

jps可以查看当前服务器上的java进程的pid,此时hadoop102,hadoop103,hadoop104上的yarn服务都启动了Web端查看HDFS的NameNode

- 浏览器中输入:http://hadoop102:9870

注意:这里是在本机的电脑上输入,如果没有配置本机电脑上的hosts映射就hadoop102需要输入ip地址,

我们可以修改C:\Windows\System32\drivers\etc\host文件,写入ip地址的映射1

2

3192.168.109.102 hadoop102

192.168.109.103 hadoop103

192.168.109.104 hadoop104- 查看HDFS上存储的数据信息

- 浏览器中输入:http://hadoop102:9870

Web端查看YARN的ResourceManager

- 浏览器中输入:http://hadoop103:8088

- 查看YARN上运行的Job信息